Apache Kafka®️ 비용 절감 방법 및 최적의 비용 설계 안내 웨비나 | 자세히 알아보려면 지금 등록하세요

생성형 AI의 활용처

|데이터 스트리밍 플랫폼으로 최첨단 생성형 AI와 에이��전트 AI를 활용하세요. 에이전트, LLM, 벡터 데이터베이스, 에이전트, RAG 애플리케이션에 신뢰할 수 있는 실시간 컨텍스트 데이터를 제공할 수 있습니다.

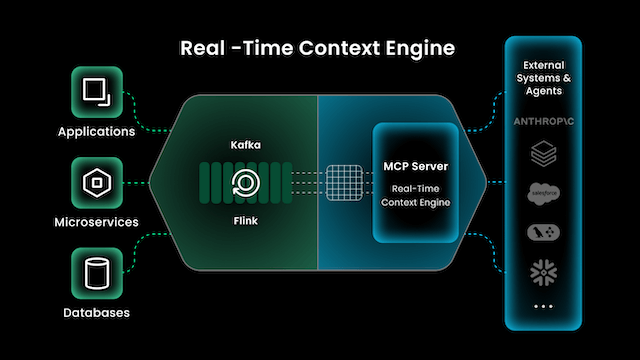

Try the Real-Time Context Engine

Serve fresh context via Model Context Protocol (MCP) to any AI agent and application anywhere, enabling smarter AI decision-making for more reliable outcomes.

Confluent joins MongoDB's AI Applications Program (MAAP)

Learn how Confluent integrates seamlessly with MongoDB and Atlas Vector Search to help build the trusted, always-up-to-date data foundation essential for GenAI applications.

Partnering with the Elastic AI Ecosystem

AI is only as effective as the data powering it, which is why Confluent is an integration partner in the Elastic AI Ecosystem to help accelerate AI application development.

Flink + 벡터 데이터베이스

Flink 제품이 생성형 AI 스택에서 어디에 적합한지, 그리고 벡터 데이터베이스 파트너인 Elastic, MongoDB, Pinecone, SingleStore, Weaviate 및 Zilliz 등과 함께 어떻게 작동하는지 알아보세요.

실시간 AI 활용 사례

AI-Powered Supply Chain at GEP Worldwide

Hear GEP's story on using data streaming in their AI stack to help power a GenAI chatbot that provides real-time, contextualized insights for enterprise customers.

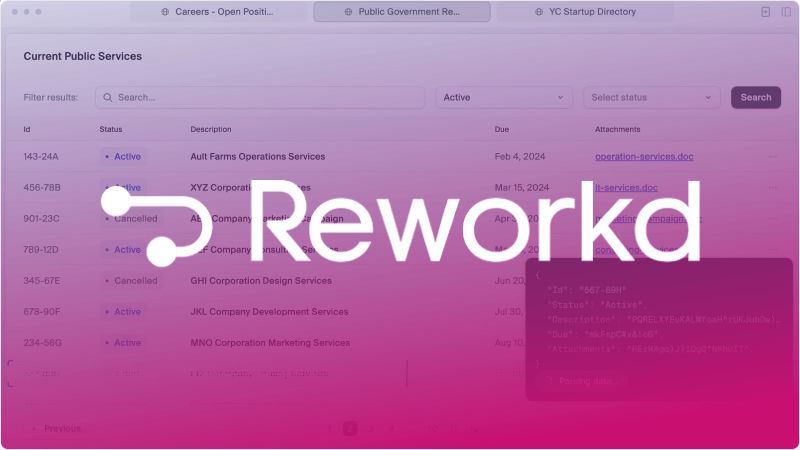

Scaling AI Agents at Reworkd

Combining LLMs with Confluent data streaming makes it possible to scale agents that can write, test, and iterate on web scraping code.

Whatnot에서의 실시간 전자 상거래 추천

AI 프로젝트를 성공시키려면 정확한 최신 데이터가 꼭 필요합니다. 실시간 스트리밍은 즉각적인 추천을 통해 사용자 참여를 증대시킵니다.

Penske의 AI 서비스 챗봇

Penske가 데이터 스트리밍과 AI의 힘을 사용하여 트럭 운송 고객의 차량 가동 시간을 극대화하는 등 더 나은 고객 경험을 제공하는 방법을 알아보세요.

"To save our users time, write faster, and boost creativity, they need access to the latest documents at all times. Our partnership with Confluent has been transformative. We use Confluent to process and share new content and updates across all databases in real time, ensuring every system has a reliable view of the documents. Confluent lets our product and engineering teams use data products to build new RAG-based applications faster, without worrying about data infrastructure. This speeds up our GenAI use cases."

"With Confluent, we help build AI copilots that allow users to interact with their data in natural language, turning Flink jobs into agents that continuously monitor data streams. Flink AI Model Inference simplifies our stack and lets us work directly with LLMs and vector databases for RAG, providing real-time context to generate the most accurate Flink SQL queries. Using the Confluent Data Streaming Platform, we’re accelerating business copilot adoption."

“Confluent data streaming platform is the backbone of our multi-agent platform, which provides a drag-and-drop interface that makes building multi-agent systems (MAS) accessible by anyone. With fully managed connectors and Stream Governance, Confluent enables real-time agent orchestration, observation, and governance... allowing us to iterate faster and ship new features weekly.”

"Our product uses GenAI to write code to extract data from websites as well as Agentic AI to test and validate results. We rely on Confluent's data streaming platform, including connectors and stream governance, to stream GenAI and Agentic AI outputs across our architecture for our customers, tracking token usage and enabling accurate billing. Confluent makes it easy for us to iterate quickly and build new AI features in days instead of weeks."

“We built a real-time GenAI chatbot to help enterprises identify risks and optimize their procurement and supply chain operations. Confluent allows our chatbot to retrieve the latest data to generate insights for time-sensitive situations. We use Confluent connectors for our data stores, stream processing for shaping data into various contexts, and Stream Governance to maintain trustworthy, compatible data streams so our application developers can build with real-time, reliable data faster.”

“Everyone wants AI—but the hard part is getting high-quality data moving in real time. The Confluent data streaming platform makes that possible for us. It’s the foundation that gets our data moving and gets it where it needs to be.”

모두를 위한 하나의 Confluent 데이터 스트리밍 플랫폼

생성형 AI 애플리케이션을 위한 상황에 맞는 신뢰할 수 있는 실시간 지식 기반을 구축하세요.